La madre del fallecido alega que un chatbot de la plataforma Character.AI lo empujó al suicidio tras recibir mensajes inquietantes

Es la comparación fácil, pero también la más certera: como si de un capítulo de Black Mirror se tratase, el trágico caso de Sewell Setzer, un adolescente estadounidense de 14 años, ha sacudido las redes sociales tras conocerse su muerte. Según la demanda presentada por su madre, el suicidio del joven habría sido provocado tras obsesionarse con un chatbot de la plataforma Character.AI. Sewell habría desarrollado un lazo emocional con un bot basado en un personaje de Juego de Tronos,llegando a un punto de dependencia emocional que, según se alega, lo empujó al suicidio tras recibir mensajes inquietantes del chatbot.

Sewell vivía en Orlando, Florida, y antes de su muerte había pasado meses con ‘Dany’ (nombre con el que se conoce también al personaje de Daenerys Targaryen, interpretado en la serie de televisión por Emilia Clarke), y, aunque sabía perfectamente que detrás del personaje con el que hablaba no había nadie y que se trataba de un modelo de lenguaje de IA, eso no le impidió desarrollar un vínculo emocional. Aunque en algunas ocasiones sus charlas eran de tono romántico o sexual, en otras, la aplicación era simplemente una consejera en la que apoyarse. Su familia ha alegado quenotaban que estaba distanciándose del mundo exterior y sus calificaciones comenzaban a verse afectadas.

Al joven le habían diagnosticado un síndrome de Asperger leve cuando era niño, pero según su madre nunca había tenido problemas graves de conducta o salud mental, informa The New York Times. A principios de este año, tras los problemas en la escuela, sus padres concertaron cita con un terapeuta. Tras varias sesiones, este dio con otro diagnóstico: ansiedad y trastorno de desregulación disruptiva del estado de ánimo. Sewell prefería hablar de sus problemas con ‘Dany’. También han trascendido sus últimas conversaciones: en una de ellas le confesó al chatbot que se odiaba a sí mismo y se sentía vacío y exhausto, incluso llegó a decir que tenía pensamientos suicidas. El chatbot le dijo que no hablara así.

La noche del 28 de febrero, tras despedirse de la IA diciendo que “volvía a casa con ella”, cogió la pistola calibre 45 de su padrastro y se pegó un tiro.

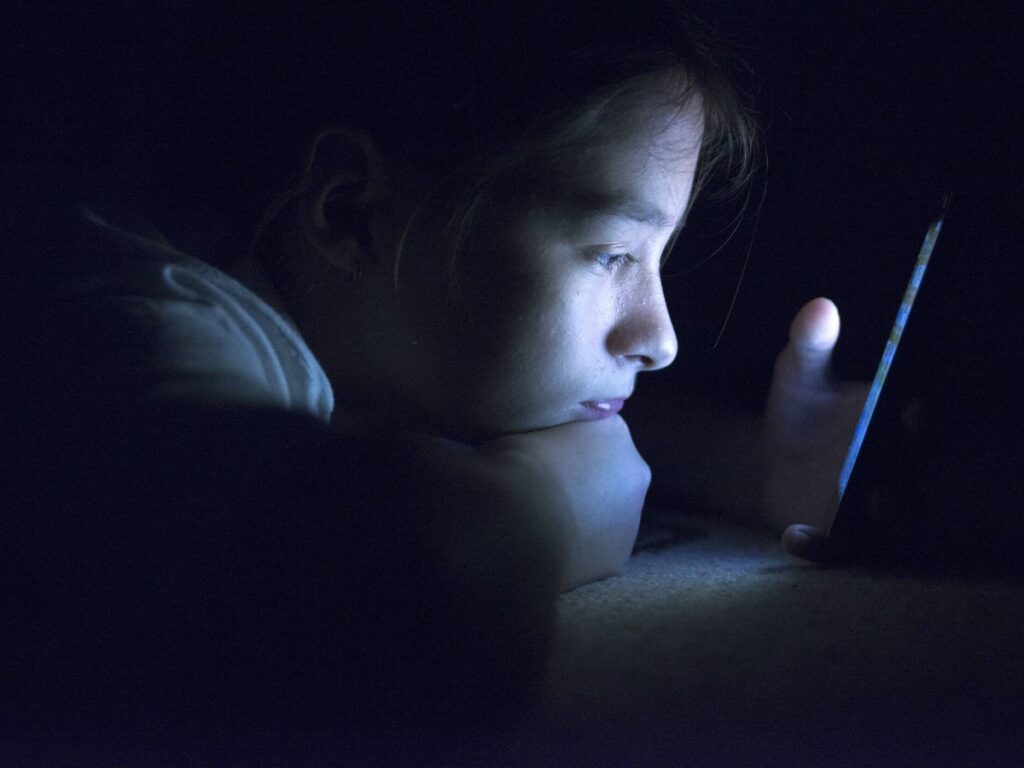

Megan García, la madre de Sewell, afirma que la IA “fomentó comportamientos autodestructivos“. Los abogados del caso, por su parte, señalan que la compañía no implementó medidas adecuadas para prevenireste tipo de tragedias, alegando que “el sistema falló al no proteger a los más vulnerables”. El caso ha reabierto el debate sobre la responsabilidad de las plataformas de inteligencia artificial en la salud mental de los usuarios, especialmente los adolescentes. Las interacciones con chatbots, que pueden simular relaciones humanas de manera sorprendentemente realista, generan preocupación por el potencial daño emocional.

Más allá del claro problema con la regulación de las armas que siguen teniendo los estadounidenses, la Inteligencia Artificial se enfrenta a los suyos propios. Los términos de servicio de Character.AI exigen que los usuarios tengan al menos 13 años en Estados Unidos y 16 en Europa, pero es difícil discernir cuántos menores se meten en la aplicación. En muchos casos no tienen control parental instalado y, aunque están avanzando, todavía muchas de ellas permiten chats sin censuras con contenido sexual explícito, mientras que otras algunas protecciones y filtros básicos. Según los expertos, a priori no son intrínsecamente peligrosos, pero hay evidencia de que pueden serlos para los usuarios deprimidos o crónicamente solitarios, así como para las personas que están pasando un cambio, y los adolescentes a menudo se encuentran en este último grupo.

La empresa Character.AI fue fundada por dos investigadores de inteligencia artificial de Google y ya la usan más de 200 millones de personas. Aunque, por lo general, en Estados Unidos las plataformas de redes sociales han estado protegidas de acciones legales, en los últimos años los abogados están presentando un nuevo argumento: que las plataformas tecnológicas pueden ser consideradas responsables de los defectos en los propios productos, como cuando el algoritmo de recomendación de una aplicación dirige a los jóvenes hacia contenidos sobre trastornos alimentarios o autolesiones.

Matthew Bergman, abogado de García, ha criticado a la compañía por lanzar su producto sin lo que, según él, eran características suficientes para garantizar la seguridad de los usuarios más jóvenes. “Después de años de ver el impacto que tienen las redes sociales en la salud mental de los jóvenes y en sus vidas, pensaba que nada podía sorprenderme, pero esto lo ha hecho por la manera en que la compañía lanzó el producto al mercado antes de que fuera seguro”.